【ROBOTECH2011】聴覚フィードバックを用いて発話動作を

自律獲得できる香川大澤田教授の「発話ロボット」

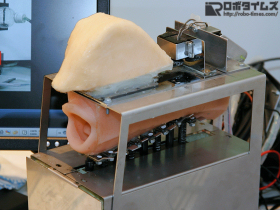

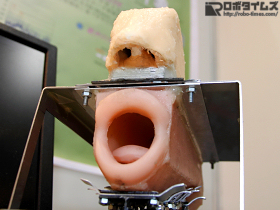

今回のROBOTECHの出展ロボットの内で、最も話題になったロボットのひとつが、この香川大学工学部知能機械システム工学科教授の澤田秀之氏の研究室で開発されたロボットだろう。「聴覚フィードバックを用いて自律的に発話動作を獲得する発話ロボット」である。「人間の音声生成器官を機械モデルで再現した発話ロボットの構築」、「聴覚フィードバックを用いた自律的発話動作の獲得」、「歌声の生成」の3つを研究目的に開発された。

ロボットの構成は、エアーポンプ(コンプレッサー)、人工声帯、シリコンラバー製の声道(唇~口腔内~のどの辺り)と鼻腔(鼻にかかる鼻音の再現に必要)、マイクロフォン、制御用コンピューターからなる。それらは人でいうところの肺、声帯、声道と鼻腔、聴覚機構、脳というわけだ。ロボットは、人と同様の手法を用いて、それらをすべて機械による動作でもって行い、音声の生成を行う仕組みである。なお、コンプレッサーは騒音の関係で展示会では使用できず、発話そのものはビデオでの紹介となっていた。口を動かしたり、人の声を聞いてその発音と同じ口の形にしたり、そして発声練習を行った後に「かごめかごめ」を歌ったりする動画は、研究室のサイトにアップされている(こちら)。

動画を見た感じと、現場でロボットそのものを見たり話を伺った感じでは、シリコンラバーという非常に柔らかい素材で声道を作っているため、唇がとにかくよく動く。動画で見る限りでは、唇の動きはやや誇張されたイメージだ。現状、歌うロボットといえば、独立行政法人産業技術総合研究所の「HRP-4C 未夢」が思い浮かぶが、彼女の場合、まだ口をすぼめる「う」の形を作れないのだが、澤田氏の「発話ロボット」を用いれば、そこもクリアできるので、コラボレーションしてみてはいかがなものかと思ったりもする。外見はなかなかインパクトのある、かなり異色のロボットであった。